領導此項研究的是知名台裔神經科學家、UCSF醫學院神經外科主任張復倫(Edward Chang),他投入腦機介面研究已有10多年。其團隊在2021年7月於《NEJM》發表,首次將癱瘓者試圖說話時的大腦活動訊號,翻譯成單字和句子並呈現於螢幕上,當時每分鐘可打出15個字。

張復倫表示,「在這項新研究中,我們將試圖說話時的大腦活動訊號翻譯成文字的速度,加快到每分鐘約78個字;不僅如此,我們還可以將此大腦訊號直接轉換成可以聆聽的合成語音,並在數位化身上呈現準確的臉部動作。」

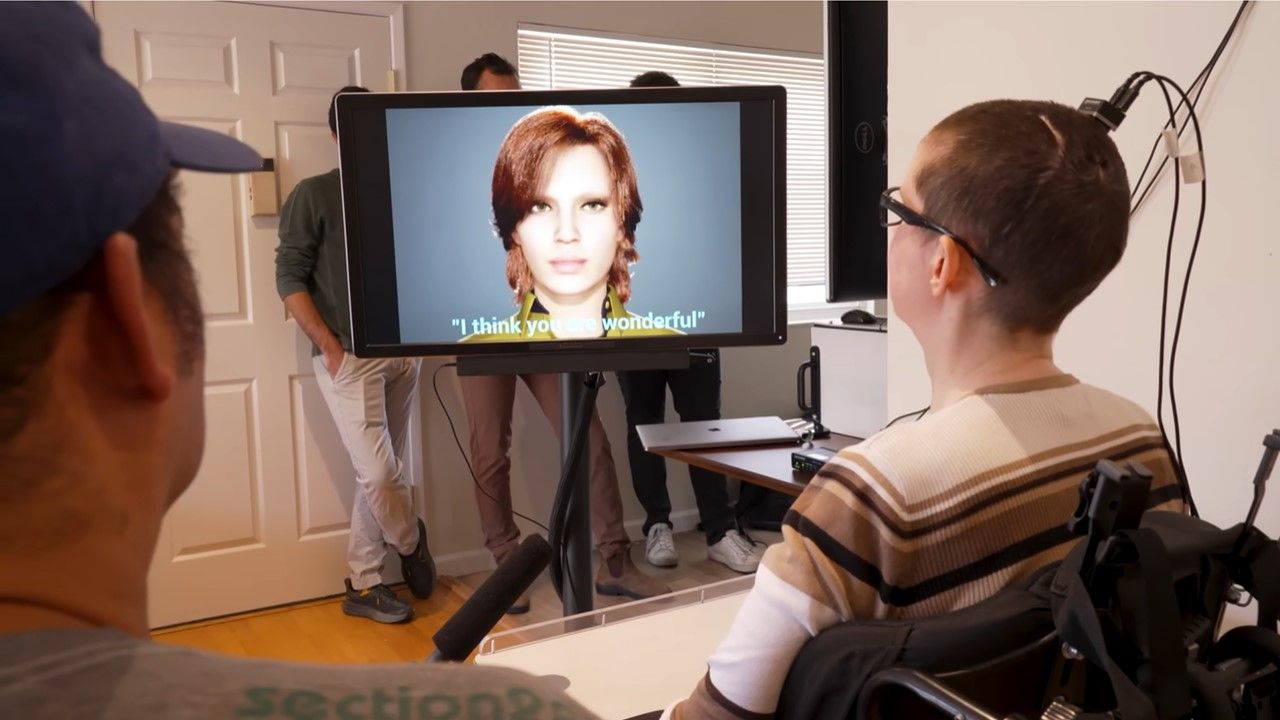

影片:

參與此項研究的是一名48歲婦女Ann,她在18年前發生腦幹中風,導致其嚴重癱瘓,經過多年的物理治療後才能轉動頭部與控制笑或哭等臉部肌肉動作,不過,能讓她說話的肌肉仍然動也不動。

研究團隊將一個含有253個電極、薄如紙張的長方形電極片,植入至Ann的大腦語言區域的皮層表面,並在其頭部設置一個端口以電纜連接到電腦。此技術稱為腦皮層電圖(electrocorticography, ECoG),能同時記錄數千個神經元的綜合活動。如果Ann沒有中風,這些電極接收到的神經訊號,原本可能會傳送到她的舌頭、下巴、喉嚨和臉的肌肉。

Ann與研究團隊一起訓練系統的人工智慧演算法好幾週,她需要從一個含有1024個單字的對話詞彙表中,重複地在嘗試說不同的短語,直到電腦能辨識她每個音素(phonemes)獨特的神經活動模式。(編按:音素是指語音中的最小聲音單位,例如,「Hello」包含四個音素:HH、AH、L和OW。)

使用這種方法,電腦只需學習39個音素就能解讀英語中的任何單字,這不僅提高了系統的準確性,還使其速度提高3倍。

而為了創建數位分身,研究團隊開發出一種合成語音演算法,以Ann中風前、在婚禮上演講的影像檔案來訓練,打造出一個聽起來像她本人的個人化合成語音。

研究團隊也藉助一套Speech Graphics公司開發的臉部動畫軟體,並透過機器學習將Ann大腦訊號轉化成虛擬角色臉部的肌肉運動,包含下顎、嘴唇、舌頭的移動,以及表達快樂、悲傷和驚訝等情緒的臉部表情。

Ann對於聽到數位分身成功代替她講話,表示「感覺很有趣,這就像聽到一位老朋友的聲音。」她並說:「參與這項研究給了我一種使命感,我覺得我正在為社會做出貢獻,感覺就像我又找到工作了。這項研究讓我感到真正地生活!」

張復倫表示,我們的目標是讓癱瘓者恢復一種完整而真實的溝通方式,也就是人們與他人交談時最自然的方式。

研究團隊表示,下一階段的關鍵是打造出不需要電線連接的腦機介面。

參考資料:https://www.ucsf.edu/news/2023/08/425986/how-artificial-intelligence-gave-paralyzed-woman-her-voice-back

論文:https://www.nature.com/articles/s41586-023-06443-4

(編譯/劉馨香)